|

|

| (6 dazwischenliegende Versionen von 2 Benutzern werden nicht angezeigt) |

| Zeile 1: |

Zeile 1: |

| | + | {{Infobox-v |

| | + | <!-- Gruppe: Header --> |

| | + | |typ=Projekt |

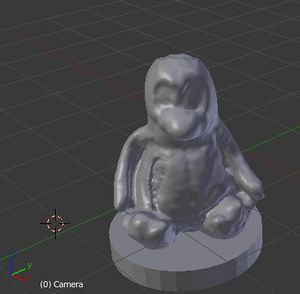

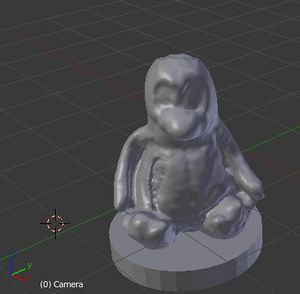

| | + | |image=reconstructme_axel_pinguin.jpg |

| | + | |image_note= |

| | + | <!-- Gruppe: Footer --> |

| | + | |qrcode |

| | + | <!-- Gruppe: Basisinformationen --> |

| | + | |kategorien= |

| | + | |beschreibung=Objekte dreidimensional einscannen |

| | + | |ansprechpartner=Florian, Axel, Rick |

| | + | |autoren= |

| | + | |mitwirkende= |

| | + | |einweisung= |

| | + | |links= |

| | + | <!-- Gruppe: Statusinfos --> |

| | + | |standort= |

| | + | |standort_seit= |

| | + | |status={{Prüfe Aktualität|Immer mal wieder mit rumspielen}} |

| | + | |status_seit=2013-02 |

| | + | |beginn=2011-05 oder eher |

| | + | |ende= |

| | + | |letzteWartung= |

| | + | <!-- Gruppe: Technische Infos --> |

| | + | |hersteller= |

| | + | |modell= |

| | + | |leistung_elektrisch= |

| | + | |drehzahl= |

| | + | |gewicht= |

| | + | |einsatzzweck= |

| | + | <!-- Gruppe: Bestandsinformationen --> |

| | + | |anzahl= |

| | + | |anzahl_seit= |

| | + | |menge= <!-- Wenn "Anzahl" als Begriff nicht passt --> |

| | + | |menge_seit= |

| | + | |datumAnschaffung= |

| | + | |kosten= |

| | + | |finanzierung= |

| | + | <!-- Weitere Felder --> |

| | + | |zusatzinfo= |

| | + | }} |

| | + | [[Category:QR:todo]] |

| | + | |

| | Wir wollen 3D-Bilder von Objekten oder Personen erstellen, um den [[3D-Drucker]] damit zu füttern. | | Wir wollen 3D-Bilder von Objekten oder Personen erstellen, um den [[3D-Drucker]] damit zu füttern. |

| | | | |

| − | == Scivi == | + | == Kinect == |

| | + | Microsofts Kinect hat eine Farbkamera und einen Tiefensensor und sollte damit zum 3D-Scannen gut geeignet sein. Wir müssen nur noch die richtige Software dafür finden. Offensichtlich gibt es einen Mindestabstand von ca. 50 cm, sonst erkennt die Kinect nichts mehr. |

| | | | |

| − | Das [http://vr.tu-freiberg.de/scivi/ 3D Scanning Framework (TU Freiberg)] scannt Objekte, die innerhalb von vier [https://www.cs.utah.edu/gdc/projects/augmentedreality/ Markern] stehen, als point cloud ein. Das Framework läuft, die Kinect muss nur ordentlich mit einem Schachbrettmuster kalibriert werden. Und man braucht einigermaßen gleichmäßiges (Tages-)Licht, damit die Marker zuverlässig erkannt werden. Offensichtlich gibt es einen Mindestabstand von ca. 50 cm. Kleine Objekte (auf dem Drehtisch) sind problematisch. | + | === ReconstructMe === |

| | + | [http://reconstructme.net ReconstructMe] <strike>sollte sich auch mal jemand angucken.</strike> haben sich mittlerweile Rick und Axel angeguckt. Geht gut. Vor allem mit Gesichtern. |

| | + | |

| | + | === Scivi === |

| | + | |

| | + | Ist leider nicht wirklich benutzbar. War wohl ein Ein-Semester-Uni-Projekt als Proof of Concept. Ich habe die Leute angeschrieben, aber weiterentwickeln werden sie es wohl nicht. |

| | + | |

| | + | Das [http://vr.tu-freiberg.de/scivi/ 3D Scanning Framework (TU Freiberg)] scannt mit der Kinect Objekte, die innerhalb von vier quadratisch angeordneten [https://www.cs.utah.edu/gdc/projects/augmentedreality/ Markern] stehen, als point cloud ein. Man braucht allerdings einigermaßen gleichmäßiges (Tages-?)Licht, damit die Marker zuverlässig erkannt werden (größere Marker werden besser erkannt). |

| | + | |

| | + | Beim Scannen nimmt man mehrere Aufnahmen aus verschiedenen Perspektiven auf. Jede neue Aufnahme wird zur Pointcloud hinzugefügt. Im Moment funktioniert das nicht richtig. Je nach Drehwinkel gibt es eine Verschiebung von bis zu 2 cm. |

| | | | |

| | Zum Kalibrieren kann man [http://nicolas.burrus.name/index.php/Research/KinectRgbDemoV6 Kinect RGBDemo] benutzen. In dem Archiv sind auch verschiedene Marker und das Schachbrettmuster. | | Zum Kalibrieren kann man [http://nicolas.burrus.name/index.php/Research/KinectRgbDemoV6 Kinect RGBDemo] benutzen. In dem Archiv sind auch verschiedene Marker und das Schachbrettmuster. |

| | | | |

| − | Scivi spuckt eine [https://secure.wikimedia.org/wikipedia/en/wiki/PLY_%28file_format%29 PLY]-Datei aus, die müsste für den 3D-Drucker in [https://secure.wikimedia.org/wikipedia/en/wiki/STL_%28file_format%29 STL] umgewandelt werden. --[[User:Florian|Florian]] 10:10, 11 November 2011 (CET) | + | Scivi berechnet aus der Pointcloud ein Mesh und speichert das als [https://secure.wikimedia.org/wikipedia/en/wiki/PLY_%28file_format%29 PLY]-Datei ab. Die muss z. B. mit MeshLab für den 3D-Drucker in [https://secure.wikimedia.org/wikipedia/en/wiki/STL_%28file_format%29 STL] umgewandelt werden. |

| | + | |

| | + | Scivi ist leider ein Uni-Projekt, das ein Semester lang entwickelt wurde und nun halb fertig und aufgrund der Verschiebung nicht wirklich benutzbar ist. Ich habe einmal in den Code geguckt, finde mich da aber überhaupt nicht zurecht. Außerdem werden da Berechnungen durchgeführt, die man eigentlich nicht selbst machen will. |

| | | | |

| − | == TO DO == | + | == Normale Kamera == |

| | + | (Ole, hier bitte weitere Erkenntnisse einfügen) --[[User:Florian|Florian]] 11:06, 16 October 2012 (UTC) |

| | | | |

| − | * Kalibrierung mit Schachbrettmuster

| + | [[Category:Projekt]] |

| − | * Optimierung der point cloud (mit Poisson Surface Reconstruction)

| + | |

| − | * Umwandlung von PLY nach STL

| + | |

| − | * [http://vr.tu-freiberg.de/scivi/?page_id=17 Scan Tablet oder Frame] basteln

| + | |

Aktuelle Version vom 2. November 2022, 20:24 Uhr

| Objektinfo: 3D-Scan

|

|

Basisinformationen:

Kategorien:

Projekt, Kategorisiere dieses Objekt!

|

Beschreibung:

Objekte dreidimensional einscannen

|

Ansprechpartner:

Florian, Axel, Rick

|

|

Statusinfo:

| Status

|

Immer mal wieder mit rumspielen (aktuell?) Immer mal wieder mit rumspielen (aktuell?)

(Seit 2013-02)

|

| Beginn

|

2011-05 oder eher

|

|

|

|

|

|

|

|

|

|

| QR neu generieren (Was ist das?)

|

Wir wollen 3D-Bilder von Objekten oder Personen erstellen, um den 3D-Drucker damit zu füttern.

Kinect

Microsofts Kinect hat eine Farbkamera und einen Tiefensensor und sollte damit zum 3D-Scannen gut geeignet sein. Wir müssen nur noch die richtige Software dafür finden. Offensichtlich gibt es einen Mindestabstand von ca. 50 cm, sonst erkennt die Kinect nichts mehr.

ReconstructMe

ReconstructMe sollte sich auch mal jemand angucken. haben sich mittlerweile Rick und Axel angeguckt. Geht gut. Vor allem mit Gesichtern.

Scivi

Ist leider nicht wirklich benutzbar. War wohl ein Ein-Semester-Uni-Projekt als Proof of Concept. Ich habe die Leute angeschrieben, aber weiterentwickeln werden sie es wohl nicht.

Das 3D Scanning Framework (TU Freiberg) scannt mit der Kinect Objekte, die innerhalb von vier quadratisch angeordneten Markern stehen, als point cloud ein. Man braucht allerdings einigermaßen gleichmäßiges (Tages-?)Licht, damit die Marker zuverlässig erkannt werden (größere Marker werden besser erkannt).

Beim Scannen nimmt man mehrere Aufnahmen aus verschiedenen Perspektiven auf. Jede neue Aufnahme wird zur Pointcloud hinzugefügt. Im Moment funktioniert das nicht richtig. Je nach Drehwinkel gibt es eine Verschiebung von bis zu 2 cm.

Zum Kalibrieren kann man Kinect RGBDemo benutzen. In dem Archiv sind auch verschiedene Marker und das Schachbrettmuster.

Scivi berechnet aus der Pointcloud ein Mesh und speichert das als PLY-Datei ab. Die muss z. B. mit MeshLab für den 3D-Drucker in STL umgewandelt werden.

Scivi ist leider ein Uni-Projekt, das ein Semester lang entwickelt wurde und nun halb fertig und aufgrund der Verschiebung nicht wirklich benutzbar ist. Ich habe einmal in den Code geguckt, finde mich da aber überhaupt nicht zurecht. Außerdem werden da Berechnungen durchgeführt, die man eigentlich nicht selbst machen will.

Normale Kamera

(Ole, hier bitte weitere Erkenntnisse einfügen) --Florian 11:06, 16 October 2012 (UTC)